90 Schuss in 10 Sekunden feuerte der Attentäter von Las Vegas im Oktober 2017 ab. Das entspricht ungefähr der Kapazität einer vollautomatischen Schusswaffe mit 98 Schuss in 7 Sekunden. Zum Vergleich: Beim Attentat in Orlando 2016 waren es 24 Schuss in 9 Sekunden. In einer Grafik visualisierte die New York Times die in den Attentaten abgefeuerten Schüsse pro Sekunde: Jeder Punkt ein Schuss. Die Grafik selbst sieht nicht spektakulär aus; trotzdem gewann sie den Malofiej Award 2018 in der Kategorie Breaking News.

Das Bemerkenswerte an der Grafik ist nicht das, was man sieht, sondern das, was man hört: nämlich die schnelle Schussfolge und die massive Anzahl der Schüsse. Jeder Schuss ein dumpfer Ton der Gewalt – als würde man im Kugelhagel stehen.

von Prof. Dr. Wibke Weber, Professorin für Medienlinguistik mit Schwerpunkt Visuelle Kommunikation und Mitglied des INDVIL-Forschungsteams

Journalistische Datenvisualisierungen zum Hören sind bisher selten. Wie der Begriff schon sagt, geht es ja um das Visualisieren von Daten. Erst die Visualisierung macht die Daten zugänglich. Doch im Fall der «New York Times»-Grafik kommt zur visuellen Darstellung noch die klangliche Ebene dazu: die auditive Transformation von Daten. Man spricht von Sonifikation: Daten werden übers Hören zugänglich und erlebbar gemacht. Denn Hören ist nochmal anders als Sehen.

Hören ist immer emotional. Wir hören eine Melodie und sind gerührt; wir hören ein Geräusch und sind erschrocken; wir hören ein Signal und sind alarmiert; wir hören eine Stimme und sind beruhigt. Während visualisierte Daten in Form von Balkendiagrammen und Graphen oft objektiv und nüchtern wirken, lösen sonifizierte Daten Emotionen aus.

Numerisch, visuell, auditiv

Datenvisualisierungen, die auf Sound setzen, folgen damit einer dreifachen Logik:

- einer nüchternen Zahlenlogik, die auf mathematischer Berechnung beruht, verpackt in Tabellenform und Programmiercode.

- einer Bildlogik: damit ist der Transfer der Daten ins Visuelle gemeint. Die Bildlogik ist also eine sekundäre Bedeutungsebene, die zudem subjektive Züge trägt, denn Visualisieren ist immer ein Akt der Interpretation.

- einer akustischen Logik: dem Hörbarmachen der Daten. Diese dritte Ebene kann entweder die visuelle Aussage verstärken oder die Visualisierung erweitern. Letzteres ist der Fall bei der «New York Times»-Grafik, wo die Schüsse sofort Bilder vom Attentat hervorrufen. Das stumme Liniendiagramm vermag dies nicht.

Das Ohr erfasst Dinge differenzierter und sensibler als das Auge. Wenn wir genauso gut sehen könnten wie hören, dann würden wir eine 10-Watt-Glühlampe aus 1’000 Kilometer Entfernung erkennen. Wir hören über ein Spektrum von 10 Oktaven, das Auge schafft nur eine.

The sound of data

Über mehrere Oktaven geht auch die Datenvisualisierung der Berliner Morgenpost. Das Datenteam hat den tiefen Fall der SPD in Deutschland vertont, basierend auf 3’838 Umfragen von Januar 1998 bis Ende Februar 2018. Man sieht die Linie im Diagramm auf- und absteigen und hört, wie die Partei über die Jahre immer weiter in den Keller rutscht. Der tiefe Schlusston klingt dramatisch und endgültig.

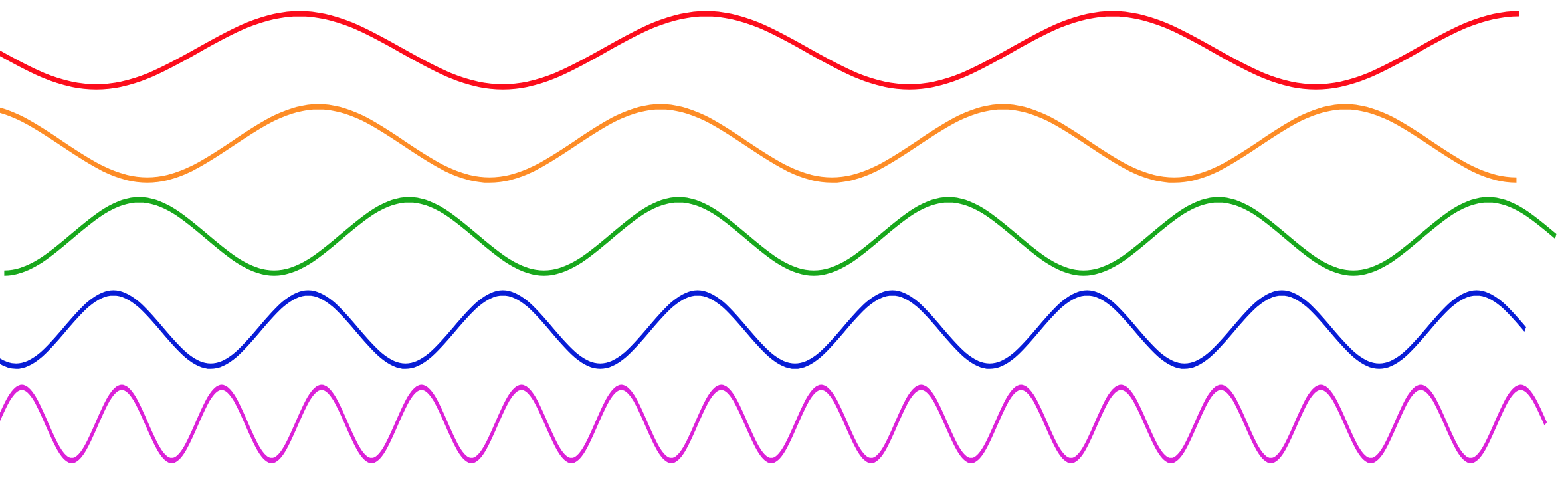

Ästhetische Stilmittel in Datenvisualisierungen, ihr multimodales Zusammenspiel und ihre Wirkung untersuchen wir im Forschungsprojekt Innovative Data Visualization and Numeric-Visual Literacy (INDVIL). Ein animierter Graph kann eindrücklicher wirken als ein statischer, ein akustischer emotionaler als ein animierter. Die Gestaltungspalette an visuellen und akustischen Variablen scheint dabei unendlich: Punkte, Linien und Flächen als visuelle Basiseinheiten von Diagrammen können unterschiedlich gestaltet und variiert werden in Grösse, Muster, Richtung, Form, Farbe, Tonwert und Position. Diese Basiseinheiten sind mit fortschreitender Technik um weitere Variablen erweitert worden, z. B. um Bewegung mit den Subvariablen Geschwindigkeit, Richtung, Flimmern, Rhythmus und Synchronisation.

Auch die auditiven Stilmittel sind vielfältig, wie das Sound Design zeigt. Allein der Datensound der beiden Fallbeispiele setzt sich aus verschiedenen Parametern zusammen: Lautstärke, Tonhöhe, Tondauer, Klangfarbe, Tempo, Rhythmus, Harmonie, Musikstil. Wie verändert sich die Aussage einer Visualisierung, wenn die Daten im Vivaldi-Stil hörbar gemacht werden? Sollen die Schüsse eines Attentäters realistisch klingen oder eher symbolisch sonifiziert werden? Mit welcher Methodik wurden die Daten in Töne transformiert, welche Programmierung liegt zugrunde? Ermöglicht die auditive Variante eine neue Sichtweise auf die Daten? Und wie glaubwürdig ist der Datensound?

Fragen, die gerade mit den neuen Technologien wie Augmented und Virtual Reality (VR/AR) oder im Zusammenhang mit der künstlichen Intelligenz nach Antworten verlangen. AR und VR erlauben uns, direkt in die Daten einzutauchen, mit Balken- und Kreisdiagrammen zu interagieren, in Timelines und Karten hineinzuzoomen. Dann geht es nicht mehr nur darum, Daten zu sehen, sondern sie mit allen Sinnen zu erleben.

- Forschungsprojekt INDVIL Innovative Data Visualization and Visual-Numeric Literacy

- Ein Megatrend – und (noch) keiner macht mit

- Virtual Reality – Teure Spielerei oder Storytelling mit Zukunft?

- Vom Sichtbarmachen und Zeigen. Storytelling heute

- Daten statt Worte – Journalismusausbildung im Zeitalter von Big Data