ChatGPT kann Ihnen und mir als Mitarbeiterin der ZHAW Hochschulbibliothek in einigen Bereichen Arbeit abnehmen. Doch kann der Chatbot auch bei einer Literaturrecherche helfen? Ich habe das Tool bei einer Recherche getestet. ChatGPT aus Sicht einer Bibliothekarin.

Hilfe! Ich finde diese Quellen nicht!

Kürzlich beriet ich in der Rechercheberatung eine Person, die gerade inmitten einer Recherche für ihre erste Semesterarbeit stand. Sie zeigte mir ihre Literaturliste und sagte, dass sie die nötigen Literaturartikel in ZHAW swisscovery nicht finden könne. Ich prüfte also als erstes die DOIs und stellte fest, dass alle Links nicht funktionierten. Daher suchte ich im Internet nach den Titeln – doch Fehlanzeige. Ich tippte auch die Namen der Autor:innen in die Suchmaschine – auch diese existierten nicht.

In den letzten Monaten sahen wir in der Hochschulbibliothek hin und wieder Literaturlisten, die von ChatGPT generiert wurden. Sie warfen bei den Nutzenden jedoch mehr Fragen auf, als dass sie sie beantwortet hätten.

Das Problem mit den falschen Referenzen

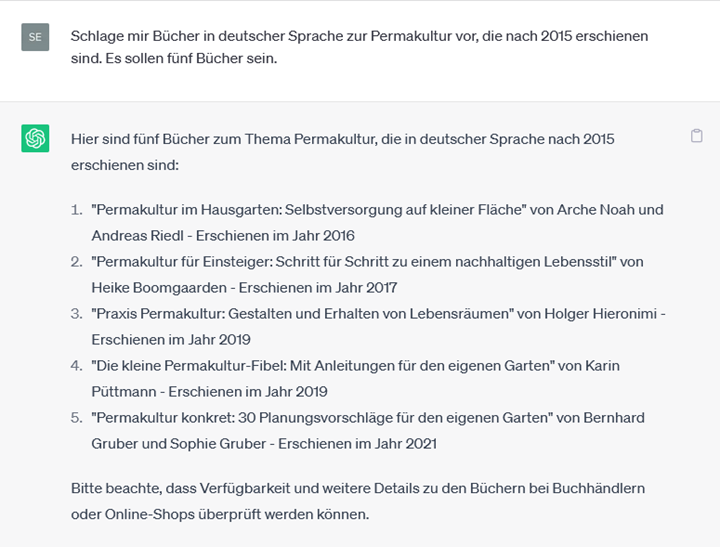

Neugierig habe ich ChatGPT getestet und gab ihm den Befehl, eine Liste von zehn Büchern zum Thema „Permakultur“ auszuwerfen. Das Ergebnis war in Ordnung. Die Maschine lieferte thematisch passende Bücher mit korrekten bibliografischen Angaben. Da die ausgegebene Literatur in englischer Sprache war, forderte ich ChatGPT dazu auf, den gleichen Befehl für Bücher auf Deutsch auszuführen, dieses Mal mit Erscheinungsdatum ab 2015. Das Ergebnis war dieses Mal jedoch ernüchternd: In der Ergebnisliste war kein einziges Buch mehr zu finden, welches es tatsächlich so gegeben hätte. Die Untertitel, Autor:innen und Jahresangaben waren von ChatGPT «halluziniert» worden, wie es einige Expert:innen nennen (Agrawal et al., 2023; Borji, 2023, S. 11; Loser, 2023).

Das Problem ist bekannt: ChatGPT gibt Referenzen aus, die nicht korrekt sind (Agrawal et al., 2023; Day, 2023). Um diese fehlerhaften Angaben nachvollziehen zu können, lohnt es sich, die Funktionsweise von ChatGPT genauer anzuschauen. Das Tool ist ein sogenanntes Large Language Model (kurz: «LLM») und wurde mithilfe einer riesigen Menge Text trainiert. Zusätzlich besteht es aus einer Vielzahl mathematischer Funktionen. Wenn ich eine Anfrage in ChatGPT eingebe, berechnet das Tool eine möglichst sinnvolle Wortfolge, die es als Antwort ausgibt (Cox & Tzoc, 2023; Wolfram, 2023). Eine Antwort von ChatGPT kann also richtig sein, muss aber nicht (Borji, 2023, S. 11; Davis, 2023).

Weitere Grenzen von ChatGPT

Das Büro für Technikfolgenabschätzung beim Deutschen Bundestag hat eine Studie zu ChatGPT und anderen Computermodellen zur Sprachverarbeitung herausgegeben (Albrecht, 2023). Darin sind weitere Schwächen in Bezug auf die Recherche aufgelistet:

Mangelnde Aktualität

Wir können ChatGPT nicht für eine Internetrecherche nutzen, da der Chat in seinem Algorithmus nicht auf das Internet zugreift. Die Textmengen, mit denen er trainiert worden ist, reichen lediglich bis ins Jahr 2021. Darauf weist ChatGPT auch beim ersten Login hin (Hahn, 2023).

Keine Nennung von Quellen

ChatGPT zeigt uns nicht transparent auf, auf Grundlage welcher Quellen der Chat seine Antworten erzeugt. Die Aussagen von ChatGPT lassen sich daher nicht nachvollziehen. Darüber hinaus ergeben sich diesbezüglich auch urheberrechtliche Fragen (Hahn, 2023, Loser, 2023.

Verschleierung von Unwissenheit

Verschiedene Studien zeigen, dass ChatGPT falsche Angaben als Wahrheit verkauft

(Albrecht, 2023, S. 40; Azaria, 2022; Borji, 2023).

Fazit

ChatGPT kann einiges – zum Beispiel unterstützt es beim Ideen finden, beim Zusammenfassen von Inhalten oder bei der Rechtschreibung.[S(2] Wichtig ist es, die ausgegebenen Antworten kritisch zu hinterfragen. Eine Internetrecherche ersetzt ChatGPT jedoch (noch) nicht. Es ist nicht ausgeschlossen, dass ChatGPT oder andere Tools dies in einiger Zeit werden tun können. Unternehmen wie Google, Meta und Microsoft arbeiten daran, Sprachmodelle und andere Technologien weiter in ihren Produkten zu implementieren. Dem Chatbot der Suchmaschine Bing liegt beispielsweise GPT-4 zugrunde (Albrecht, 2023, S. 22, 62; Cox & Tzoc, 2023).

Wie nutzen Sie ChatGPT? Schreiben Sie es in die Kommentarspalte!

Falls Sie das Tool erst noch testen wollen: https://chat.openai.com/

Hinweis: Dieses Thema wirft natürlich Fragen im Zusammenhang mit der Verwendung bei Leistungsnachweisen auf. In diesem Kontext bietet die Richtlinie der ZHAW zur «Verwendung generativer KI-Systeme bei Leistungsnachweisen» Angehörigen der ZHAW eine klare Orientierung.

Siehe auch den Blogbeitrag: Wenn nicht ChatGPT, wie dann? KI-Tools für die Literaturrecherche

Titelbild: „Plaudern, Ai, Chatbot“ von Alexandra Koch, unter Pixabay Lizenz

Ein Beitrag von Vanessa Seyffert

Wo nicht anders genannt, steht dieses Werk unter Lizenz CC BY 4.0 ZHAW, Hochschulbibliothek (Stand 24.08.23). Die Screenshots sind davon ausgenommen.

Quellenverzeichnis: Agrawal, A., Mackey, L., & Kalai, A. T. (2023). Do language models know when they’re hallucinating references? (arXiv:2305.18248). arXiv. https://doi.org/10.48550/arXiv.2305.18248 Albrecht, S. (2023). ChatGPT und andere Computermodelle zur Sprachverarbeitung – Grundlagen, Anwendungspotenziale und mögliche Auswirkungen (TAB-Hintergrundpapier Nr. 26). Büro für Technikfolgenabschätzung beim Deutschen Bundestag (TAB). https://doi.org/10.5445/IR/1000158070 Azaria, A. (2022). ChatGPT usage and limitations. https://hal.science/hal-03913837 Borji, A. (2023). A categorical archive of ChatGPT failures (arXiv:2302.03494). arXiv. https://doi.org/10.48550/arXiv.2302.03494 Cox, C., & Tzoc, E. (2023). ChatGPT: Implications for academic libraries. https://doi.org/10.5860/crln.84.3.99 Davis, P. (2023, Januar 13). Did ChatGPT just lie to me? The Scholarly Kitchen. https://scholarlykitchen.sspnet.org/2023/01/13/did-chatgpt-just-lie-to-me/ Day, T. (2023). A preliminary investigation of fake peer-reviewed citations and references generated by ChatGPT. The Professional Geographer. https://doi.org/10.1080/00330124.2023.2190373 Hahn, S. (2023, März 16). GPT-4: «In einer Welt rasender KI-Entwicklung» – Fakten auf einen Blick. heise online. https://heise.de/-7546721 Loser, P. (2023, Juli 4). KI an Schweizer Hochschulen: Unis zittern vor Chat-GPT – diese Berner Professorin wagt ein Experiment. Tages-Anzeiger. https://www.tagesanzeiger.ch/unis-zittern-vor-chat-gpt-diese-berner-professorin-wagt-ein-experiment-142577951107 Wolfram, S. (2023, Februar 14). What is ChatGPT doing … and why does it work? Stephen Wolfram Writings. https://writings.stephenwolfram.com/2023/02/what-is-chatgpt-doing-and-why-does-it-work/