Was ist der Einfluss von KI-Tools wie ChatGPT auf Cybersecurity? Im Januar 2023, drei Monate nach der Veröffentlichung von ChatGPT, gab Cybersecurity-Experte Marc Rennhard eine erste Einschätzung zu den Chancen und Risiken des KI-Tools. Nun gibt es das KI-Tool schon ein Jahr: Was hat sich in der Zwischenzeit bewahrheitet oder geändert? Wir fragen ZHAW Expert:innen, die sich mit künstlicher Intelligenz oder Cybersecurity befassen, nach ihrer Meinung und ihren Erfahrungswerten.

Marc Rennhard ist Professor für Informatik, mit Spezialgebiet Informationssicherheit, und leitet an der School of Engineering die Fachabteilung Informatik, Elektrotechnik und Mechatronik. Seit 2022 arbeitet er im Projekt Cyber Resilience Network for the Canton of Zurich (CYRENZH).

Stephan Neuhaus ist Dozent für Informatik am InIT, sein Spezialgebiet ist ebenfalls Informationssicherheit und er forscht beispielsweise zur Sicherheit von Daten und dem Internet der Dinge.

Ricardo Chavarriaga leitet die “Responsible AI Innovation Group” am Center for Artificial Intelligence (CAI) und lehrt und forscht zu Themen wie künstlicher Intelligenz, Neurotechnologie und KI-Governance.

Manuela Hürlimann ist Expertin in den Bereichen Computerlinguistik, Natural Language Processing (NLP) und Machine Learning (ML), sowie Mitglied im Kompetenzzentrum für Generative KI.

Erste Einschätzung: Was sind die Chancen der KI-Tools für die Cybersecurity-Community?

Marc Rennhard (Januar 2023): Ich habe das Tool ausprobiert und eine Chance für uns ist sicherlich, dass ChatGPT Schwachstellen in Programmcode finden kann. Ich kann zum Beispiel solchen Code ins Tool laden und fragen, ob dieser sicher ist oder nicht. Das funktioniert gar nicht so schlecht und wir können das Ergebnis als Zweitmeinung nutzen. Übrigens können KI-Tools teils auch Programmcode erzeugen, nebst ChatGPT gibt es dabei insbesondere GitHub Copilot zu nennen. Diese bieten viel Potential, um die Arbeit zu beschleunigen. Ich würde solchem Code aber keinesfalls blind vertrauen und immer überprüfen, ob er korrekt funktioniert und gleichzeitig sicher ist.

Update: Wie nutzt ihr ChatGPT und sind weitere Chancen aufgetaucht?

Stephan Neuhaus (November 2023): Ich selber nutze ChatGPT nicht. Im Moment arbeite ich nicht an grossen Programmen und meine Texte schreibe ich lieber selbst. In den letzten Monaten sind aber öfter Erfahrungsberichte aufgetaucht, die an der Eignung von ChatGPT und anderen Vorhersagemodellen zweifeln lassen, selbständig an Programmtexten zu arbeiten. So ist beispielsweise ChatGPT der Meinung, dass in Afrika kein Land mit dem Buchstaben K beginne. Am nächsten käme noch Kenya, «das zwar mit einem K gesprochen, aber mit einem K geschrieben» werde. Es gibt noch andere Beispiele, in denen sich ChatGPT unfähig zeigt, die Anzahl der Buchstaben in einem Wort korrekt zu bestimmen. Diese auf den ersten Blick verblüffenden Schwierigkeiten erklären sich aus der Art, wie Programme wie ChatGPT konstruiert sind. Wichtig ist, dass ChatGPT kein Verständnis von der Welt hat und keine Vernunft besitzt. Logik und Arithmetik kennt es nicht. Wenn man das weiss, kann man mit dem Programm gut arbeiten.

Ricardo Chavarriaga (November 2023): I am not an active user of ChatGPT or any other generative language model. I do see some use cases in which these tools are useful, as long as users are aware of the limitations of the tool. I think it is helpful to see these tools as an assistant that has access to a lot of knowledge with very little understanding. Therefore, it can give hints that may sound pretty convincing while being completely wrong. Hence, I don’t think they are (yet) fit for entirely replacing code or text production, but rather as help to kickstart these processes, or to explore different ways to express some ideas. Then, users should always remain in control of the final outcome, keeping a healthy skepticism on the outputs of the language model.

Manuela Hürlimann (November 2023): I totally agree with Ricardo’s comment, that the tool has “access to a lot of knowledge with very little understanding”. ChatGPT doesn’t have world knowledge or reason (because what it does is next word prediction based on a statistical model) and this doesn’t allow for covering complex cybersecurity scenarios. I also think that the user should take responsibility for the final output and evaluate it critically.

Erste Einschätzung: Was sind die Risiken von ChatGPT im Bereich Cybersecurity?

Marc Rennhard (Januar 2023): ChatGPT findet nur relativ einfache Schwachstellen, so wie eine gut ausgebildete Person sie auch finden würde. Sobald mehr Verständnis gebraucht wird, um die Sicherheitsaspekte wirklich zu verstehen, wird es zu komplex für die KI. Das Tool kann insbesondere keine höhere Logik erkennen und gelangt darum schnell an seine Grenzen. Ich denke eher nicht, dass wir mit dem Tool in absehbarer Zeit Aufgaben mit hohen Sicherheitsanforderungen in der geforderten Qualität lösen können, auch wenn sich ChatGPT sicher weiterentwickeln wird.

Update: Rückblickend, hat sich diese Einschätzung bewahrheitet oder würdet ihr etwas ergänzen/anpassen?

Stephan Neuhaus (November 2023): Ich stimme der Einschätzung voll zu.

Erste Einschätzung: Was könnte ChatGPT für Cybercriminals bedeuten?

Marc Rennhard (Januar 2023): Cybercriminals werden dadurch ebenfalls effizienter werden. Phishing-Mails zum Beispiel werden durch ChatGPT qualitativ besser und von legitimen Mails kaum unterscheidbar sein. Mit Phishing-Mails werden die Opfer auf einen Server gelockt, wo sie ihre persönlichen Daten, z.B. Benutzername und Passwort, eingeben sollen. Das Tool kann nicht nur den Text der Mails erstellen und auf Wunsch anpassen, sondern alle Schritte der Angriffskette generieren, z.B. auch den Code für eine gefälschte Login-Maske. ChatGPT ermöglicht dabei zwar nichts grundsätzlich Neues, aber es wird einfache Angriffe zugänglicher und effizienter umsetzbar machen. Bei spezialisierten Angriffen, z.B. auf die kritische Infrastruktur von Staaten, denke ich nicht, dass ChatGPT einen grossen Einfluss haben wird. Ich kann es aber nicht mit Sicherheit sagen.

Update: Hat sich die erste Einschätzung bewahrheitet, dass Cybercriminals v.a. bei einfachen Attacken, wie Phishing besser werden?

Stephan Neuhaus (November 2023): Mir sind keine Statistiken in dem Bereich bekannt, aber ich würde mich wundern, wenn Cyberkriminelle die Chance nicht nutzen würden, bessere Phishingmails zu schreiben, bzw. schreiben zu lassen. Wenn Phishing-Mails von ausländischen Kriminellen erstellt werden, kann man sie oft an ungelenken Formulierungen erkennen. Das wird mit der Verwendung von ChatGPT nicht mehr möglich sein. Neben ChatGPT gibt es ausserdem weitere KI-Tools, die beispielsweise Deepfakes von Personen erstellen können. Dies kann zu gruseligen Szenarien führen, zum Beispiel wenn Cyberkriminelle die Stimme oder Bild/Video von echten Personen nutzen, um uns in die Irre zu locken. Wenn statt Mails oder SMS eine Sprach – oder Videonachricht von der vermeintlichen Chefin oder den vermeintlichen Enkeln kommt, kann dies glaubwürdig erscheinen. Ich würde hier raten, insbesondere wenn es um Geld, Gutscheincodes oder Passwörter geht, die Nummer der Chefin/Enkel etc. selbst anzurufen und nachzufragen.

Ricardo Chavarriaga (November 2023): Yes, so far the greater risks with these tools is the possibility they bring to improve and scale phishing efforts, and make it more difficult to detect. It may be too early to have accurate statistics, but there are already reports of deepfakes of audio being used in scam efforts and signs of increasing trends in efforts for misinformation (e.g. through social media). This makes it very likely that similar trends may be happening with cybersecurity attacks.

In this point, it is important to remember that there are other ways, beyond ChatGPT, in which AI techniques can also impact cybersecurity. For instance, AI techniques can help identifying anomalous patterns for detecting cybersecurity attacks, or triggering automatic incident response processes.

Erste Einschätzung: Wie kann das Tool in der Ausbildung oder für das Freiwilligennetzwerk von CYRENZH eingesetzt werden?

Marc Rennhard (Januar 2023): Ich sehe eine grosse Chance in der Ausbildung. Studierende können beispielsweise das Tool für Übungen nutzen oder als virtueller Tutor, wobei man die Aussagen des Tools natürlich immer kritisch begutachten sollte. Auch für die Ausbildung der Personen in einer Art «freiwilligen Feuerwehr» in der Cybersecurity könnte es hilfreich sein. Aber die Cyberwehr, die wir im Projekt CYRENZH aufstellen möchten, soll primär Expert:innen, die zum Beispiel in Rente gegangen sind oder die generell einen Beitrag leisten möchten, zusammenbringen. Diese Zielgruppen bringen das geforderte Know-How oft schon mit, aber auch diese können punktuell von einem Tool wie ChatGPT natürlich profitieren, beispielsweise bei der Einarbeitung in neue Themen.

Update: Habt ihr in diesem Jahr ChatGPT in die Lehre, bei CYRENZH oder sonst wo integriert?

Stephan Neuhaus (November 2023): In meinem Bereich ist es in der Lehre nicht integriert. Ich finde die Verwendung von Tools wie ChatGPT als Tutor heikel, da es keine Vorstellung von richtig und falsch hat. Wie will man also sicherstellen, dass die Studierenden das Richtige beigebracht bekommen? Von einem Tutor möchte man ausserdem, dass er bei Bedarf erklären kann, warum eine Antwort so ist und nicht anders. Solange solche Tools aber noch nicht einmal verstehen, dass Kenya wirklich mit K beginnt, hätte ich wenig Vertrauen in solche Erklärungen.

Manuela Hürlimann: Concerning the “teaching companion”, this is a good use case, which seems rather popular these days as it’s being tried in many contexts. OpenAI also released some guidance for teachers.

Was denkt ihr? Möchtet ihr eure Erfahrungen mit uns teilen, dann schreibt gerne einen Kommentar oder eine Mail: digital@zhaw.ch.

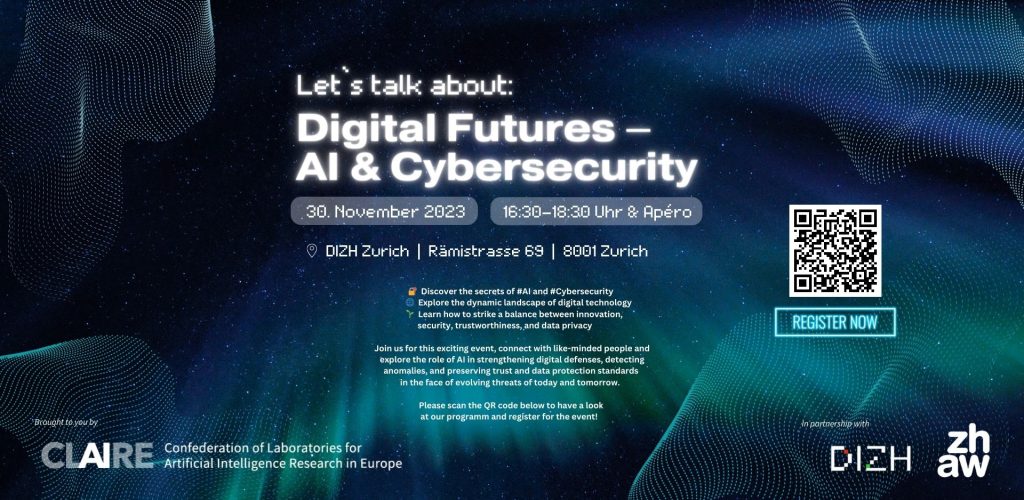

| Tipp: Um Cybersecurity und KI geht es an unserem öffentlichen Event, das ZHAW digital zusammen mit dem KI-Netzwerk CLAIRE und der Digitalisierungsinitiative der Zürcher Hochschulen (DIZH) organisiert: “Digital Futures: AI and Cybersecurity”, 30.11.2023, 16:30-18:30. Programm und Anmeldung Kommt vorbei und diskutiert mit! |